Par nature sous tension, en recherche constante de performance, les métiers de la supply chain ont souvent été précurseurs et activateurs en matière de transformation digitale.

Les enjeux actuels auxquels font face ces métiers ne font que confirmer cet état de fait : pilotage des flux physiques, financiers et administratifs, efficacité intralogistique, gestion de stocks, préparation de commandes au sein d’une stratégie omnicanale, installations automatisées pour suivre l’explosion du e-commerce…

Les questions relatives à la donnée, son accès, sa fiabilité, sa circulation et son intégrité, sont donc évidement la croisée de toutes ces préoccupations.

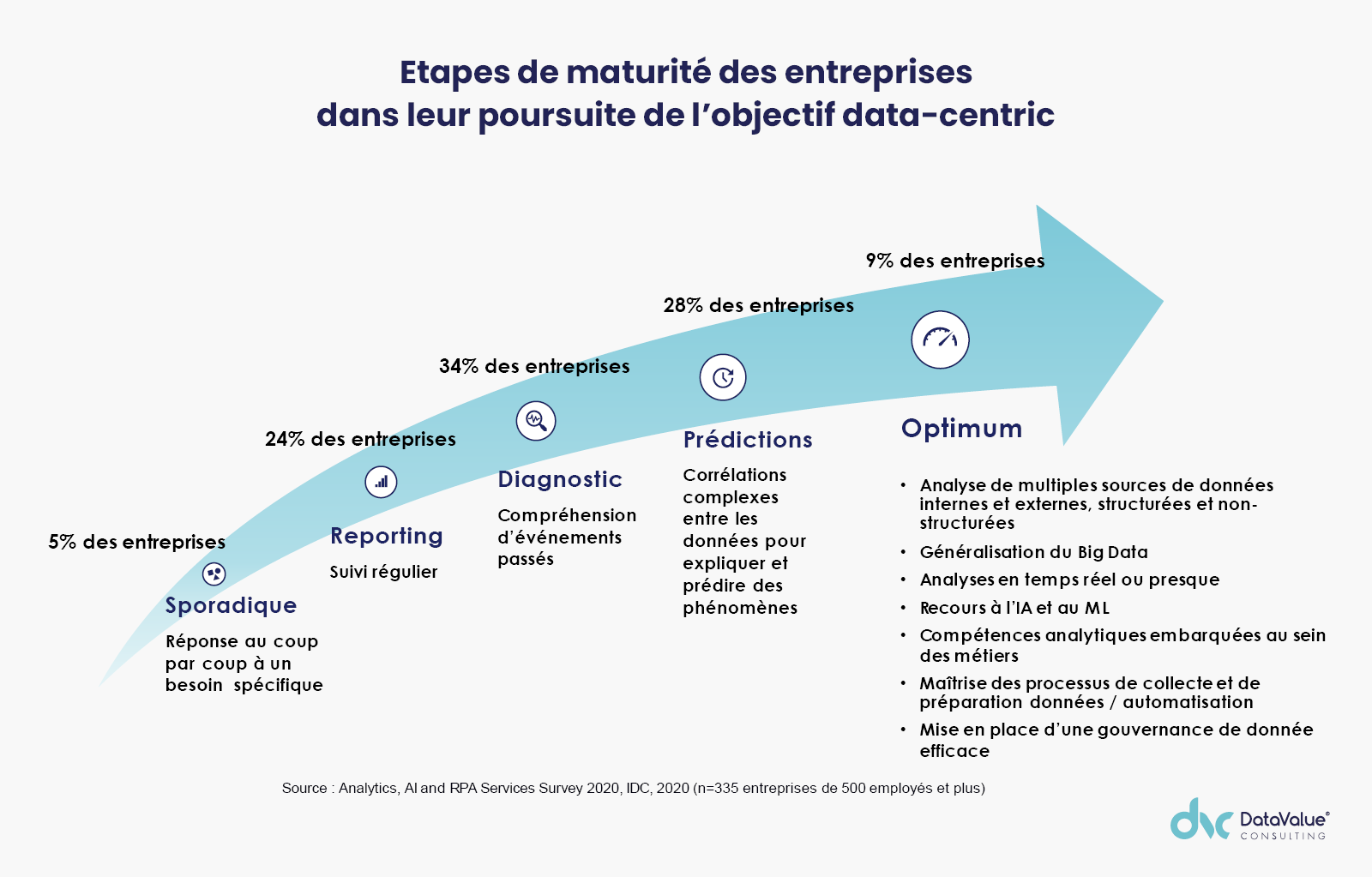

A ce titre, une récente étude IDC/Tableau « How data culture fuels business value in data driven organization » réalisée en 2021 révèle « 83% des CEO souhaitent que leur organisation soit axée sur les données », autrement dit : qu’elle soit data centric.

A l’occasion d’une conférence commune au salon Supply Chain Event, InterSystems et DataValue Consulting ont pu partager leurs visions et retours d’expérience sur ces problématiques, autour des pratiques de data fabric et de stratégie data centric.

Évolution des SI dans le Supply Chain Management

Les écosystèmes de logiciels supply chain s’articulent en majorité selon 4 principaux axes :

- Stratégique : APS (Advanced Planning System), optimisation du réseau logistique, network design,

- Tactique : Procurement (gestion des approvisionnements), planification de la production,

- Opérationnel: ERP, SCEM (Supply Chain Event Management),

- Exécution : SCEM également et SCE (Supply Chain Execution) pour rationaliser le cycle de traitement des commandes.

On peut y ajouter d’autres outils complémentaires comme un CRM (Customer Relationship Management) qui permet la gestion de la relation client et la liaison entre le commerce et la Supply Chain, un SRM (Supplier Relationship Management) pour les relations fournisseurs ou un PLM (Product Lifecycle Management) pour gérer le cycle de vie des produits.

Tous ces outils sont liés au sein d’un système décisionnel complexe et qui doit pourtant fluidifier les échanges autour de données de références.

Pour bien comprendre les enjeux des évolutions actuelles en matière de stockage et traitement de la donnée, il est intéressant d’opérer un bref rappel sur les évolutions des SI et de l’architecture des données.

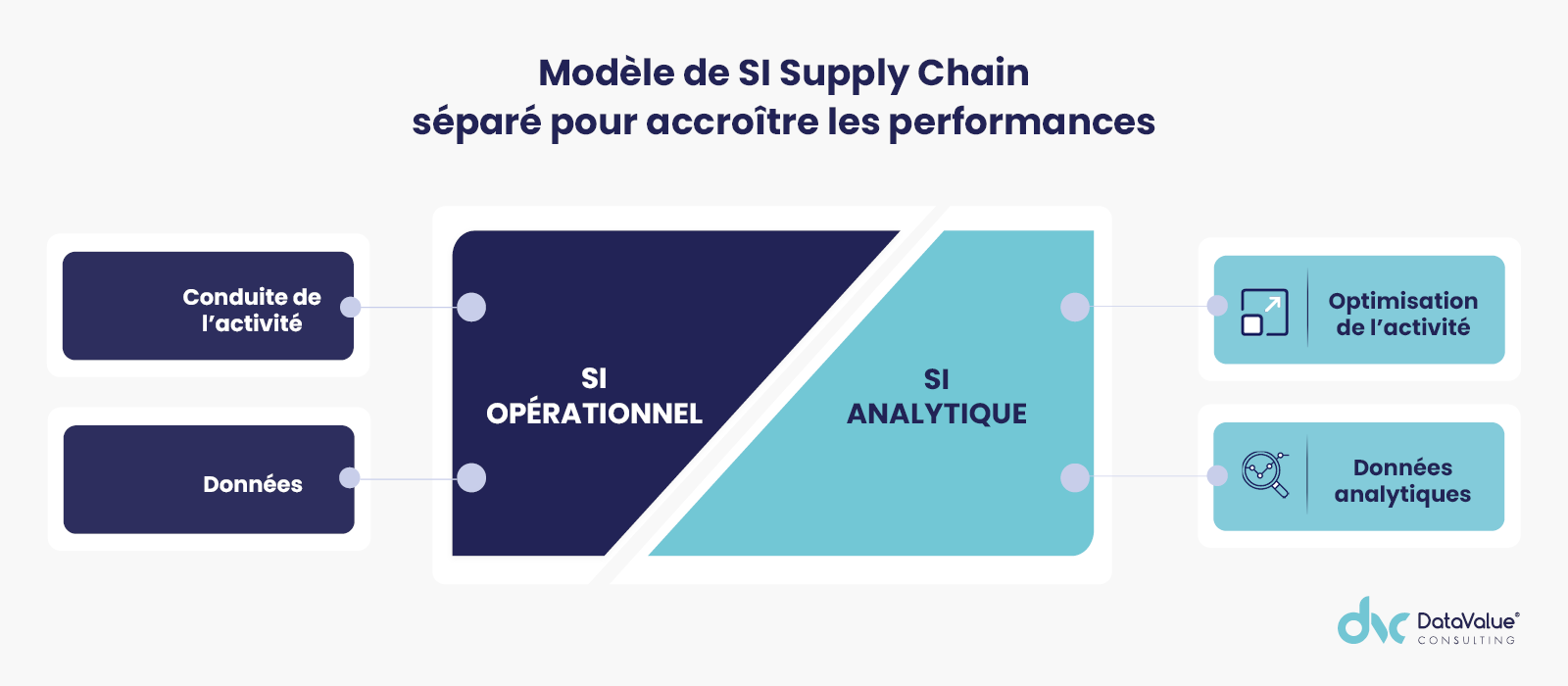

Jusqu’aux années 80, les premiers SI utilisés par les métiers de la supply chain, étaient des systèmes uniques. Un seul système d’information regroupait les données opérationnelles et analytiques, informations nécessaires à la conduite et l’optimisation de l’activité.

Au fil du temps, des usages et du développement des outils informatiques, des problèmes de performance se sont posés vers la fin des années 80, faisant apparaître les limites d’un système centralisé unique. Pour des raisons de performance, un nouveau modèle a émergé : les systèmes ont été divisés afin de pallier une désynchronisation entre les volets décisionnels et opérationnels.

Chaque métier a en effet besoin d’accéder à la donnée sous un angle particulier. Dans cette configuration, les data warehouse ont pu réconcilier les problématiques analytiques et opérationnelles, notamment par l’usage de datamarts dédiés respectivement aux RH, à la finance, à la Supply Chain, au commerce, au marketing…

L’approche alternative, plus récente, du data lake a ensuite été adoptée pour une transformation adhoc des données au dernier moment, selon chaque besoin métier. C’est en quelque sorte une spécialisation de l’analytique. La donnée n’est pas préparée en amont, selon des règles propres à l’usage final comme c’est le cas avec un data warehouse : le data lake recueille toutes les données possibles qu’elles soient structurées ou non. Le traitement est appliqué a posteriori en fonction des usages souhaités.

La 3e approche qui émerge actuellement est celle de la data fabric. Ce modèle innovant est en train de gagner du terrain. Il s’agit d’une approche transverse, d’une architecture à mettre en œuvre en interne pour optimiser la supply chain. La data fabric se pose la question de la relation entre les consommateurs de données et les sources de données.

Supply Chain Management : l’approche data centric

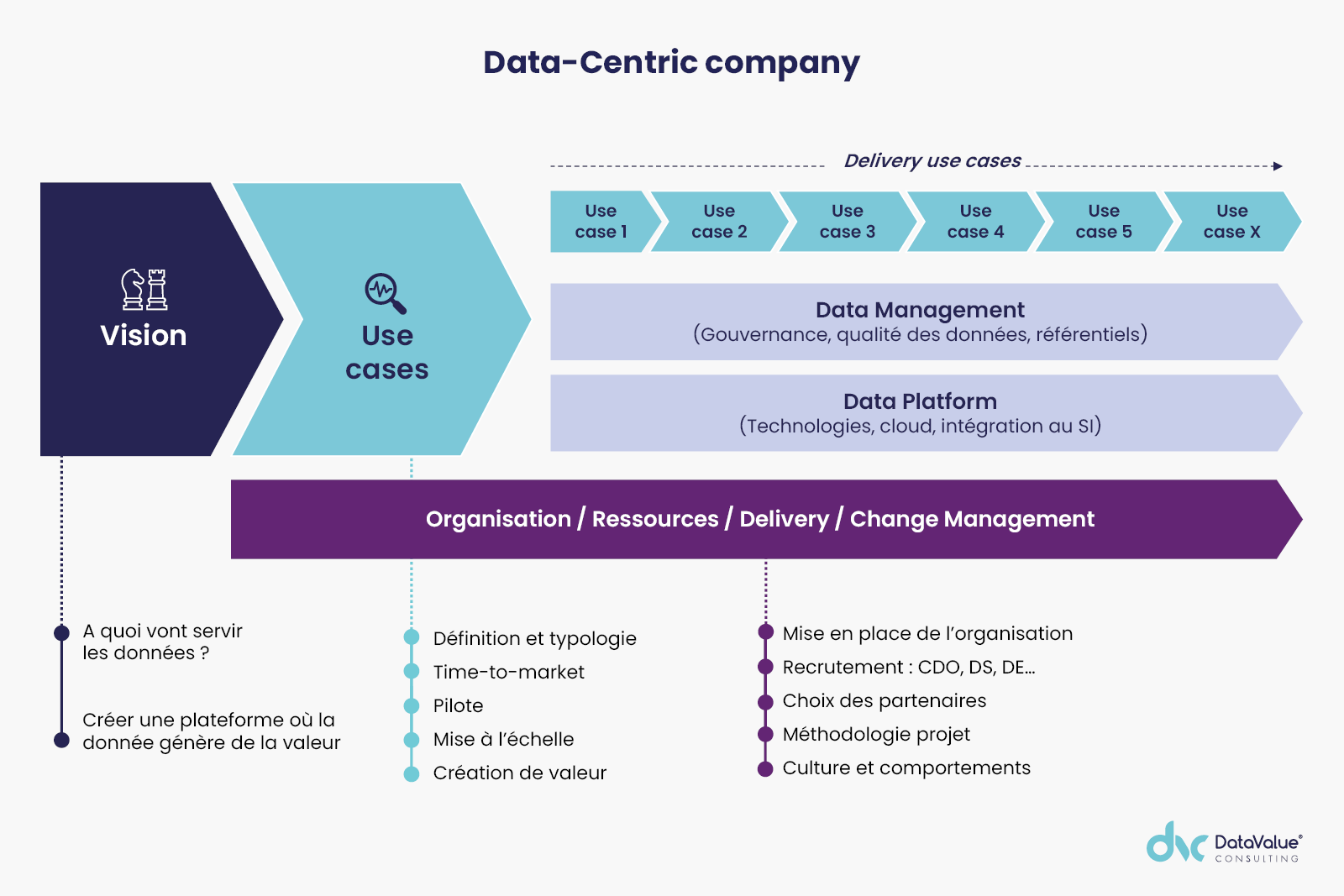

L’approche data centric va plus loin que l’approche data driven. La démarche data driven consiste à guider ses décisions et ses actions avec une recours maximal aux données. Être data centric consiste à structurer toute son activité et son organisation autour de son patrimoine de données afin de le transformer en levier de croissance, peu importe le modèle d’architecture SI choisi. Le choix de ce modèle doit découler de la stratégie data, et non l’inverse.

La démarche d’application d’une stratégie data centric est un processus qui demande un minimum de temps et un haut niveau d’implication avec une forte impulsion de la direction ainsi qu’un travail d’organisation et d’acculturation des équipes à la data.

Ce processus est constitué de plusieurs étapes : la définition par la direction d’une vision claire des usages de la donnée attendus, le recueil des besoins auprès des métiers pour définir précisément les cas d’usage, la mise en place d’une gouvernance des données avec un CDO et une équipe dédiée (Data Mangement Executive, PO, Proxy PO, Data Stewart…), la conduite du changement. Il est important de penser en avance ce change management pour garantir la réussite des projets.

Ensuite vient la question du choix de la plateforme : intégration dans le SI, data lake, data hub, cloud ou on premise, data fabric…

Dans le cadre de la supply chain et de son écosystème applicatif très riche, le respect de ces différentes étapes est d’autant plus important : la réflexion doit se baser avant tout sur les cas d’usage prioritaires qui permettront de dégager le maximum de valeur à partir du patrimoine de donnée. Il peut s’agir du suivi de taux de service, de back order, du safety stock… A noter que le développement des cas d’usage peut débuter par les cas combinant importance stratégique et facilité de mise en place mais les cas peuvent également être parallélisés.

Une data fabric pour le supply chain management

La grande diversité d’activité de la supply chain nécessite de coordonner un ensemble complexe d’intervenants et de SI différents : centrale d’achat, fournisseurs, site de production, plateforme de stockage, plateforme logistique, transport… jusqu’à la livraison et la satisfaction du client final.

Une plateforme data fabric permet de lier et monitorer les SI internes mais aussi les SI de partenaires, clients ou fournisseurs. Le traitement de la donnée est mutualisé en intégrant dans la même plateforme les volets intégration, gouvernance et traitement de la qualité. Elle va standardiser les modèles et les pratiques de gestion de la donnée pour en faciliter l’accès aux utilisateurs finaux de façon décentralisée, à la demande.

L’institut Gartner définit 5 piliers pour un modèle data fabric complet :

- Une première couche « métadonnées » avec un data catalog (ou catalogue de données) à construire avec l’aide des data stewart métier. Il s’agit d’un emplacement unique où sont centralisées toutes les métadonnées des données stockées par l’entreprise,

- Une seconde couche analytique sur un réseau de Knowledge Graph pour « activer » les métadonnées,

- Une couche d’algorithmes IA et Machine Learning enrichie avec les métadonnées « actives » pour simplifier et automatiser le modèle d’intégration de données,

- Une couche d’intégration dynamique des données pour délivrer des données intégrées dans différents formats,

- Une couche d’automatisation de l’orchestration des données.

Une plateforme data fabric permet une fluidification et une grande traçabilité entre les systèmes. Les métiers sont au courant de toutes les activités dans les différents SI et peuvent surveiller l’exploitation, même au sein de l’écosystème des partenaires.

Grâce à ce modèle de plateforme unifiée, il est possible de monitorer les performances, les coûts et l’efficacité du stockage, savoir qui utilise quoi et comment, quel que soit l’emplacement des données et des applications. En somme, la data fabric permet d’avoir une vue d’ensemble complète, en temps réel, de toute l’activité de la supply chain.

Le principe consiste à établir une cartographie des SI frontaux d’une entreprise pour recomposer un ERP : DMS (Dealer Management System : ERP pour les marchés de distribution automobile ou de véhicules industriels), solution d’administration des ventes, référentiel produits à injecter pour unifier en un seul référentiel auprès des différents acteurs (PIM), Transport Management System (TMS), data lake BI, cockpit FOREX pour suivre les cours de change dans un contexte international…

Tous ces flux peuvent seront gérés par une plateforme et une approche data fabric qui en offrira une visibilité de bout en bout grâce à une fluidification des échanges inter-applicatifs.

Les avantages finaux à retirer seront significatifs :

- Liaison des différentes applications composants le SI,

- Liaison avec les SI externes des fournisseurs, clients et partenaires,

- Partage de l’information facilité, fiabilisé et sécurisé,

- L’automatisation des processus de la supply chain,

- Tableaux de bords BI adapté à chaque métier,

- Meilleure réactivité permettant l’anticipation des problèmes ou points de rupture.

La rédaction vous conseille

> Supply Chain : comment sortir renforcé de la crise sanitaire de la Covid-19

> Comment structurer une gouvernance des données efficace ?