Votre DSI, votre responsable Data ou vous-même souhaitez mettre en production votre projet Big Data et hésitez encore… Dois-je migrer vers le cloud ? Le ROI sera-t-il au rendez-vous ? Est-ce un chantier sans fin et risqué ou, au contraire, un projet qui renforcera l’agilité de votre organisation ?

Voici les 10 raisons qui démontrent les bénéfices d’une migration vers le cloud pour un projet Big Data.

Comme dans la plupart des projets Data, rappelons que les choix technologiques (modes de stockage, type de plateforme…) doivent être effectués à partir du cas d’usage, et non l’inverse.

1. Le Big Data coûte cher

La capacité des technologies Big Data à analyser rapidement des données hétérogènes et volumineuses à travers des architectures distribuées est aujourd’hui démontrée. Cette accessibilité permet de faire émerger de puissants leviers d’analyse, de prédiction, de croissance et de compréhension d’un environnement.

Les résultats sont probants mais le chemin à parcourir pour mettre en place un projet Big Data peut s’avérer complexe et coûteux.

Le set-up cost, ou « ticket d’entrée », demeure très élevé sur des infrastructures on-premise. Même si des produits Open Source performants et sans coût de licence ont bousculé l’univers de la data, ils présentent aujourd’hui une forte complexité de mise en production (Hortonworks par exemple).

Le coût du Big Data (avec la mise en place d’un data lake) est donc si important qu’il nuit souvent à l’élaboration d’un ROI par les DSI. Et bien que les phases pilote (pouvant être gérées par un Data Lab) soient effectuées, les mises en production sont souvent retardées voire annulées…

Ces projets de mise en place d’un data lake ou d’industrialisation de cas d’usage Big Data nécessitent de nombreux investissements. Par exemple, une architecture d’une dizaine de serveur, tous nœuds confondus (stockage, calcul, administration et gestion de métadonnées) nécessitera un investissement initial important qui amènera rapidement le coût de setup à quelques centaines de milliers d’euros.

2. Le PaaS résout tout

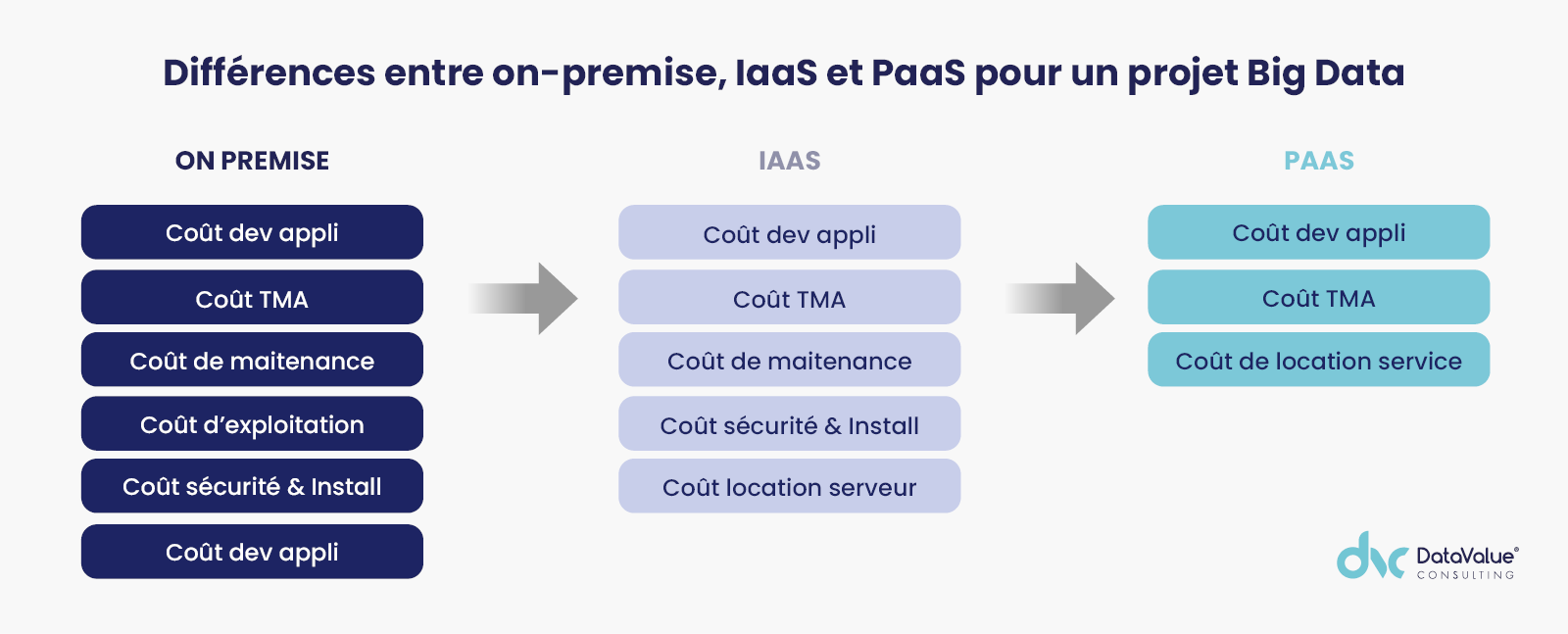

On le sait, les infrastructures on-premise présentent des coûts importants de développement applicatifs, de maintenance, d’exploitation, de sécurité, d’installation et d’achat de serveurs. Les services IaaS ont démontré depuis une vingtaine d’années les bénéfices attendus d’une infrastructure déportée. Cependant, ces services IaaS n’influençaient que très peu les coûts de déploiements et les charges de maintenances des outils et des applicatifs. Le PaaS permet au contraire de ne maintenir que les applicatifs métiers qui constituent toute la valeur du SI.

L’utilisation de services PaaS pour son projet Big Data permet de concentrer les efforts de la DSI sur les cas d’usage métiers. Et c’est précisément à ce moment-là que la valeur émerge. C’est au moment du déploiement d’un cas d’usage bien spécifique que le ROI va pouvoir être engrangé.

Le IaaS représente une location de serveurs et d’espace disque, par conséquent tous les autres coûts d’infrastructure demeurent quasiment les mêmes (voir illustration ci-dessous). Les services PaaS ne génèrent, quant à eux, que des coûts de développement et de run. L’utilisation du PaaS simplifie la mise en production du projet Big Data en permettant aux DSI de se concentrer uniquement sur les flux liés au cas d’usage, et non sur l’intégralité des données à stocker.

3. Accessibilité des données en situation de mobilité

Votre cas d’usage implique des parties prenantes basées dans des lieux géographiques éloignés ? Votre plateforme peut par exemple être utilisée par des collaborateurs répartis aux États-Unis, en France, en Allemagne, en Chine ?

L’utilisation des services cloud permet de construire une architecture distribuée qui va pouvoir rapprocher le workload des utilisateurs et réduire la latence. L’efficacité, la scalabilité et la rapidité qui en résultent permettent de favoriser le taux d’adoption des utilisateurs finaux et de sécuriser le ROI du projet.

4. Scalabilité et modularité de la plateforme

La donnée est stockée sur du stockage objet. Elle peut être manipulée autant par du SQL, du R, du Spark ou tout autre langage compatible. Au lieu de penser « type ou modèle de stockage », on va donc se concentrer sur « l’exploration et l’exploitation de la donnée ».

Au-delà du stockage, les modules de gestion de la donnée permettent de traiter les données en fonction de leurs usages en leur adjoignant des métadonnées spécifiques :

- Accès via une base de données relationnelle : migration rapide des datawarehouses on-premise vers des services optimisés.

- Accès via des données distribuées : distribution native des données sur les serveurs, gestion de la donnée sur des bases de données orientées colonnes et sur des stockages orientés Big Data.

- Accès via tous les autres types de gestion des données (stockage objet, graph…)

La scalabilité se trouve grandement facilitée. Le cloud permet de démarrer à petite échelle pour ensuite adapter la plateforme en fonction de la montée en charge et de la croissance de la volumétrie.

Enfin le cloud permet un stockage illimité, contrairement à une installation on-premise.

5. Gestion de la conformité

HIPAA, HDS, RGPD, ISO 27001, SOC 2, SOC 3… Vous êtes sûrement soumis à des normes ou standards à respecter dans le cadre de votre activité et de la gestion de votre SI.

Les socles techniques offerts par les opérateurs cloud répondent à ces prérequis. Vous allez pouvoir concevoir une solution dans un réceptacle disposant déjà d’un niveau de conformité et de sécurité à jour. De quoi vous allégez en gestion de processus et en mobilisation de ressources.

6. Sécurité

Tout comme la gestion de la conformité, les fournisseurs cloud investissent fortement dans la sécurité de leur plateforme et de leurs services. Cela offre aux entreprises clientes une garantie de sécurité. Il restera à la charge de l’entreprise d’effectuer ensuite ses propres paramétrages, de mettre en place ses processus de gestion de la conformité et de bien documenter sa plateforme.

Cependant, les fournisseurs cloud, de par leur responsabilité, sont en permanence à jour sur la mise en application des réglementations, des évolutions technologiques et des bonnes pratiques de sécurisation de la donnée.

Le recours au BYOK permet de protéger les clefs de chiffrement que l’on va utiliser auprès des fournisseurs cloud. Enfin, vous avez toujours la possibilité de concevoir une architecture hybride cloud/on-premise si la souveraineté des données reste votre préoccupation principale.

7. Interopérabilité

Dans le cadre d’une collaboration ou d’une stratégie de partage de données avec des partenaires tiers, vous aurez la capacité d’adapter vos usages à travers une composante technologique dans le cloud et ce, de façon beaucoup plus simple.

Dans une configuration on-premise, il faudrait au contraire s’engager dans la conception et le financement de tout un projet.

8. Agilité

Le cloud et le PaaS permettent de pratiquer des tests rapidement et par conséquent de prendre des décisions à l’avenant, en fonction de ces éléments de test. Ceci confère une agilité certaine à l’organisation et permet d’adapter le cycle de développement pro logiciel en fonction des besoins prioritaires.

Cette disponibilité va également permettre de réduire le time-to-market de vos projets Big Data. Tester rapidement facilite l’évaluation du ROI lié à un développement ou un cas d’usage ainsi qu’une prise de décision quant à sa poursuite ou son arrêt. Il serait en effet irréaliste d’investir dans l’acquisition d’infrastructures uniquement à but de test.

Dans le même ordre d’idée, il ne s’agit pas de développer une véritable usine à gaz pour se rendre compte ensuite que les cas d’usage nécessitent des SLA différents. La scalabilité sera donc adaptée à chaque cas d’usage. Vous optimiserez ainsi les coûts et les aspects opérationnels.

9. Tout n’est pas à redévelopper

La migration peut être freinée par l’appréhension de la DSI de devoir redévelopper tout le patrimoine applicatif. Heureusement, de nombreux produits ou services standards trouvent leurs équivalences dans le cloud et évitent de devoir tout redévelopper.

Les solutions Open Source renforcent également cet état de fait. Il s’agira donc davantage de migration applicative que de recodage.

10. Liberté d’architecture pour une plateforme moderne

Qu’il s’agisse d’investir dans un modèle relationnel, de se reposer sur la virtualisation de données, sur des base de données SQL ou NoSQL, ou même d’un DataLake… Vous pourrez répondre à différents besoins en vous inscrivant à des services spécifiques sans vous restreindre à un seul type d’architecture.

Conclusion

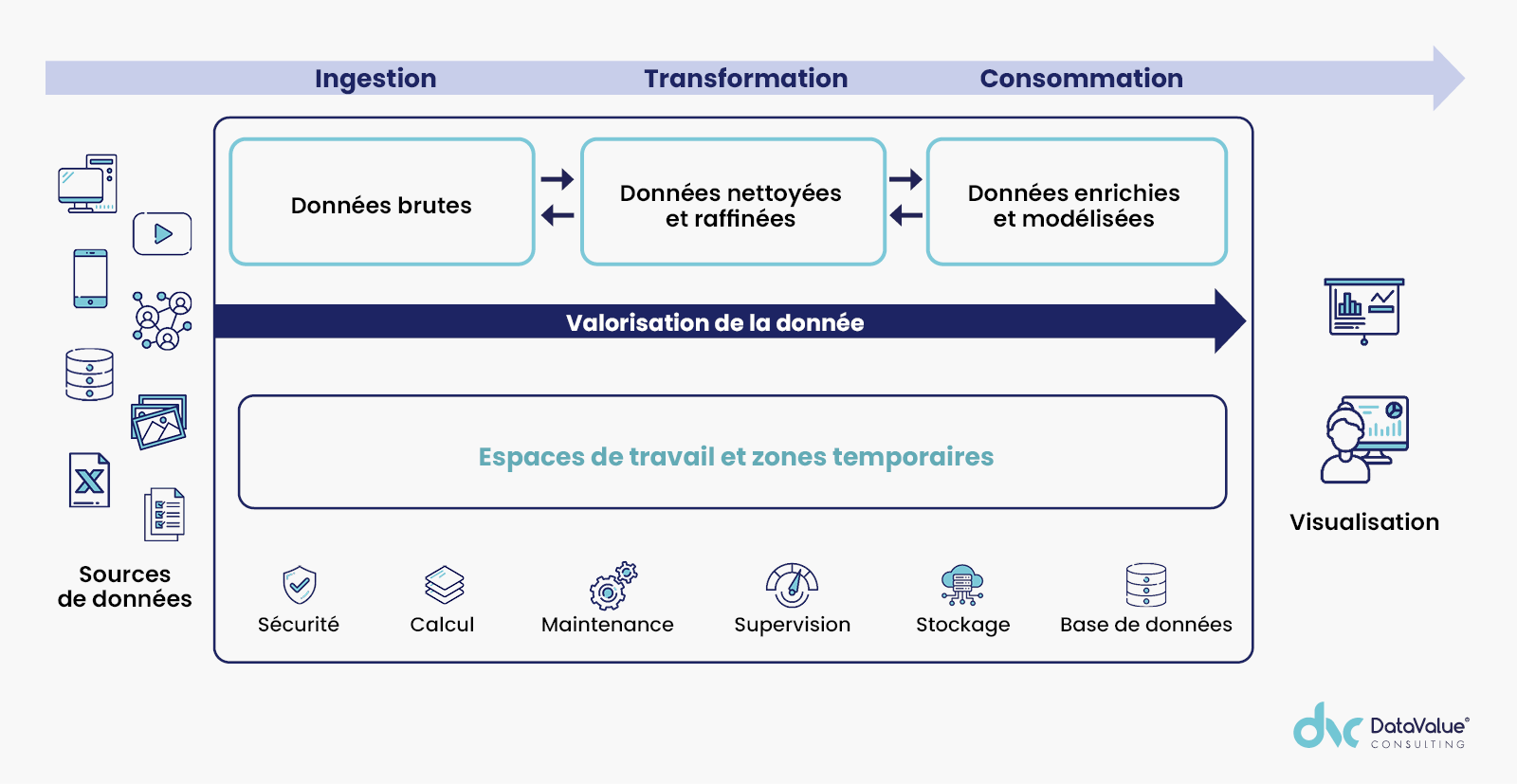

Le cloud ouvre la voie à une gestion et un usage simplifié de la data, permettant de valoriser toute la chaîne de la donnée. La capacité à se concentrer sur les cas d’usage et à appliquer des règles métiers plus rapidement sur les données va permettre d’extraire de la valeur.

Avec ses offres de services modulaires, le cloud réduit à la fois le montant et l’inertie des investissements. Privilégiant sur un plan financier l’OPEX devant le CAPEX, il optimise l’appréciation du ROI et limite de nombreux coûts. Enfin, il offre un ajustement technique parfait à la réalité des besoins de la DSI et des métiers.

La rédaction vous conseille

> Points de vigilance pour réussir sa migration Big Data

> Quels coûts directs et indirects pour votre migration Big Data ?