Dans le cadre d’une stratégie de gouvernance des données, des processus doivent être instaurés afin d’assurer une traçabilité transverse au sein de l’organisation cible tout en facilitant l’accès, l’utilisation et le partage des données.

La Data Office, piloté par le Chief Data Officer, est garant de la définition et de l’application de ces derniers.

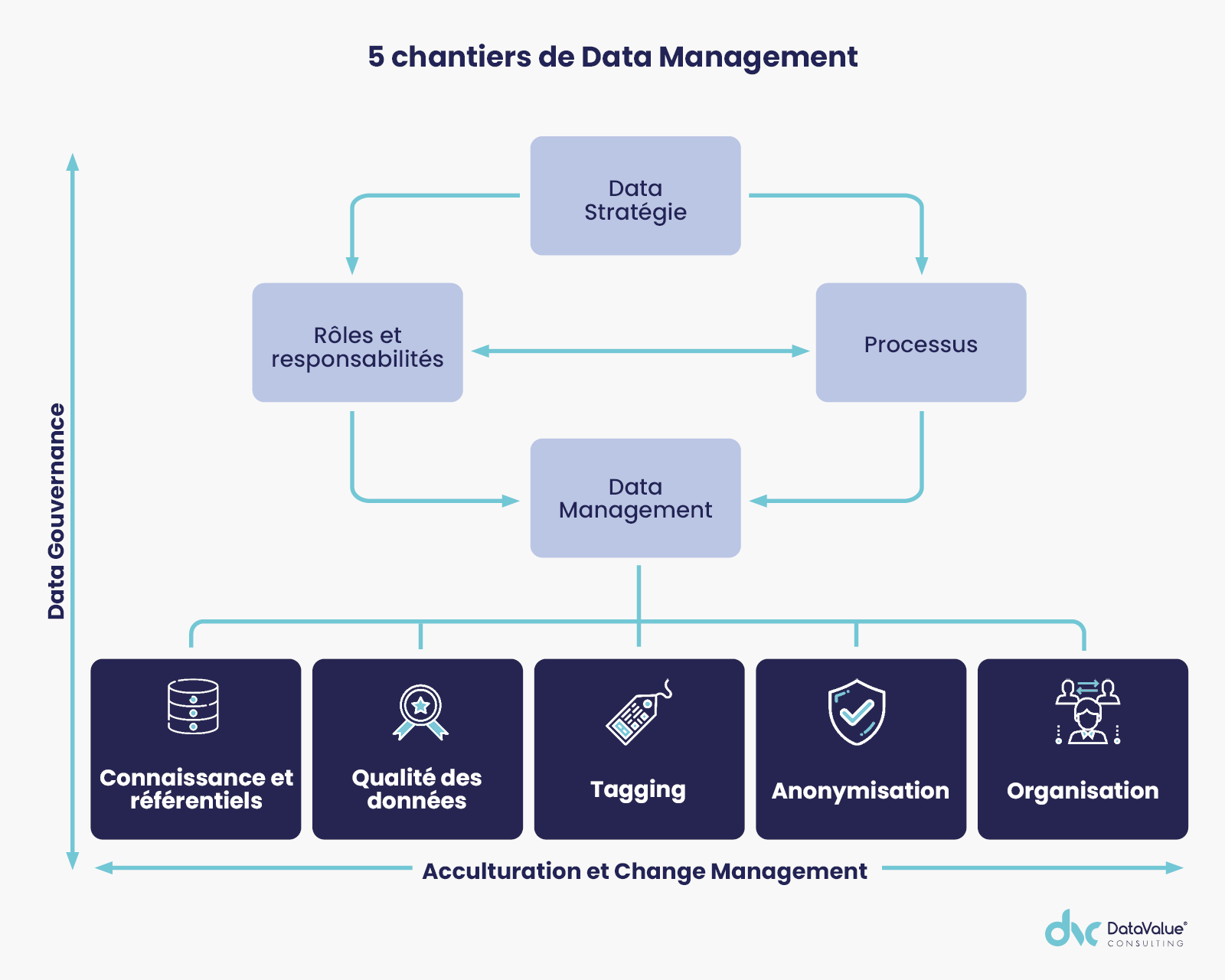

Les 5 chantiers de data management

L’ensemble de rôles, responsabilités et processus permettent d’assurer un management efficace et transparent de la donnée, à travers 5 chantiers de data management qui peuvent se décliner « by design ».

Connaissance et référentiels de données, enjeux clés d’une stratégie de gouvernance des données

Le référentiel de données est le pivot central qui stocke, centralise et cartographie les données de référence de l’entreprise. Cela peut aboutir à la mise en place d’un MDM (Master Data Management).

4 conseils pour construire un référentiel de données :

- Les outils MDM, briques importantes d’un socle data, facilitent l’usage et améliorent la qualité des informations délivrées aux autres systèmes.

- La démarche de construction est itérative (par référentiel, par métier, par fonction…). Elle est transverse et nécessite un sponsorship fort.

- Chaque référentiel (client, produit, organisation…) dispose de sa roadmap propre tout en assurant une cohérence globale.

- Le développement de son propre MDM « maison » paraît peu envisageable car les fonctionnalités à implémenter sont trop nombreuses et compliquées à maintenir.

La qualité des données, point d’alerte d’un programme de gouvernance de données

La qualité de la donnée représente en outre pour les entreprises un autre point d’alerte, qui nécessite d’être maîtrisé avant tout lancement de projet. Les premiers cas d’usage serviront par ailleurs de test à la qualité de la donnée. Au démarrage, la réalisation de cas d’usage simples présentant un nombre de données raisonnable sera favorisée.

La mise en qualité des données nécessite de suivre certains prérequis :

- Le processus de gestion de la qualité des données devra être itératif en s’appuyant sur une mise à niveau de la qualité des données « by design ».

- Les règles sont propres à chaque métier mais doivent obéir aux processus qui pérennisent les travaux de mise en qualité.

- Le choix d’un outil de gestion de la qualité des données nécessite au préalable de cartographier les usages et fonctionnalités à couvrir, avant de lister les critères de choix et de les évaluer.

- De nombreuses technologies répondent aux problématiques de la gestion de la qualité des données (les outils émergents basés sur l’IA ne sont pas encore matures, le marché est dominé à 90% par 4 familles d’outils selon le rapport d’étude MarketsandMarkets™ : Talend, Informatica, Collibra, Ab Initio).

- Le maintien de la qualité des données nécessite la mise en œuvre de bons KPI pour mesurer des critères intrinsèques aux données elles-mêmes, des critères de services liés à l’usage et des critères de sécurité lié à l’ensemble du dispositif.

- Au-delà des modèles, la réalisation de documentations, de politiques, de standards et de processus est primordiale pour la réussite d’un projet de gestion de la qualité des données.

Plan de gouvernance des données : l’importance du tagging des données

La surcouche d’information que l’on ajoute sur l’information existante pour faciliter l’acquisition, la compréhension et la manipulation des données par les utilisateurs de l’entreprise.

DataValue Consulting revient pour vous sur les prérequis à ne pas manquer pour réaliser le tagging de vos données :

- La mise en œuvre des tags s’insère dans une démarche globale de cartographie et de documentation des données de l’entreprise par la création d’une couche sémantique en langage métier qui donne du sens aux données.

- Le tagging des données de l’entreprise en un seul lot est à éviter : il faut construire « by design » de manière itérative par périmètre.

- La classification des données est un prérequis important pour le tagging. Le processus de classification peut être implémenté à plusieurs étapes : collecte des données, création d’une information (agrégats, indicateurs…), contrôle qualité, etc.

- Les outils ne sont pas une fin en soi dans un tel projet mais ils permettent d’automatiser l’industrialisation de la documentation des données de l’entreprise et sa valorisation.

Anonymisation des données, étape importante de la gouvernance des données

Les travaux en relation avec la mise en conformité des données sensibles et critiques doivent faire l’objet d’une anonymisation des données. Cette démarche intervient dans une logique de confidentialité et de protection des données.

L’anonymisation des données s’appuie sur plusieurs volets : la politique de sécurité, la cartographie des données, le maintien de l’intégrité et de la cohérence des données intra/inter-applications ainsi que les techniques de cryptage des données jugées sensibles.

Le choix des méthodes d’anonymisation doit être fait selon le cas d’usage : appauvrissement, hashage, chiffrement, masquage, obstruction, remplacement, suppression, variance, vieillissement, etc.

Par ailleurs, la prise en compte des impacts organisationnels est souvent négligée : signature d’accords de non-divulgation, accès sécurisé aux données confidentielles et sensibles, application des règles minimales d’anonymisation, adéquation des processus métiers et procédures organisationnelles.

Une solution d’anonymisation efficace est une solution exécutable en « temps réel » et répondant à trois contraintes majeures : la plus rapidité pour ne pas freiner la propagation des données, la moins destructrice possible d’information, et ayant le meilleur ratio coût/performance.

Organisation de la donnée, vers une gouvernance des données maîtrisée

L’organisation de la donnée correspond aux règles de nommage, de l’organisation technique et des espaces de stockage liés aux différentes catégories de données (données brutes, données élémentaires, données référentielles, données historisées, données techniques, données agrégées, etc).

Les 5 points clés pour réussir un projet de plateforme de données :

- Selon notre expérience, 90% des données à destination d’un data lake sont déjà structurées. La vraie nouveauté vient plutôt du mode « temps réel ».

- La réussite d’un projet de plateforme tient à la définition préalable d’un modèle d’organisation des données, matérialisé par des métadonnées et des modalités physiques, en amont des développements.

- Intégration de nouvelles sources de données dans la plateforme au fil de la réalisation de nouveaux cas d’usage.

- Une maintenance continue est nécessaire pour éviter la péremption de données sur la plateforme et l’apparition d’un « Shadow IT » avec des coûts importants de maintenance ou de stockage de données dupliquées.

- Un environnement de prototypage (type DataLab), intégré dans la plateforme disposant de l’accès à une large gamme de données et d’un dispositif de sécurité est un accélérateur pour la mise en œuvre et l’industrialisation des cas d’usage.

La gouvernance des données est devenu un enjeu majeur pour les organisations souhaitant optimiser et sécuriser l’utilisation de leurs données.

Cela implique une gestion rigoureuse et transparente de l’ensemble des données qui circulent au sein de la structure. Pour y parvenir, la mise en place d’une traçabilité transverse des données est essentielle.

![[Livre Blanc] Gouvernance des données : organisation et stratégie à adopter en 2023](https://no-cache.hubspot.com/cta/default/8316412/9f4b44ca-3325-4afa-9e31-3298b9d459f8.png)