Les organisations reçoivent d’énormes quantités de données textuelles. Lorsque ces données sont structurées (formatées dans des tables de données ou des tableurs), elles sont alors faciles à interroger, à filtrer et à analyser.

Cependant, 80 % des données textuelles existantes sont des données non structurées ou semi-structurées, qui ne disposent pas de format prédéfini. C’est le cas des documents texte, des e-mails, des images, des vidéos, ou encore des posts sur les réseaux sociaux.

L’analyse des données textuelles génère bien des difficultés et les organiser manuellement est un travail fastidieux, onéreux et qui s’expose à des risques d’erreurs humaines. C’est pour ce type de tâches que les technologies de Text Analysis, ou d’analyse de données textuelles avec le machine learning, peuvent se montrer très utiles.

L’analyse de données textuelles : qu’est-ce que c’est ?

Text Analysis et Text Analytics : quelles différences ?

Le Text Analysis est un ensemble de techniques qui permet de nettoyer et de formater les données textuelles non structurées pour en comprendre la signification et les rendre exploitables.

Plus communément connu sous l’acronyme NLP (Natural Langage Processing) ou TALN (Traitement Automatique de la Langue Naturelle), le Text Analysis combine les avancées scientifiques de 3 domaines disciplinaires que sont la linguistique, l’informatique et l’intelligence artificielle dans le but de fournir des outils pour diverses applications.

Il ne faut pas confondre Text Analysis, ou Text Mining, et Text Analytics, bien que les experts eux-mêmes ne soient pas encore tous en phase sur la limite entre ces deux appellations. Les techniques de Text Analysis préparent les données non structurées afin de les rendre exploitables par les techniques de Text Analytics.

Les techniques de Text Analytics consistent à appliquer des algorithmes, des statistiques et du Machine Learning à ces données pour pouvoir en tirer des tendances, ou toute autre information venant de données traitées par le Text Analysis.

Le Text Analysis offre des résultats qualitatifs (identification des informations importantes dans le texte lui-même, compréhension du sens du texte, etc.) alors que le Text Analytics offre des résultats quantitatifs (identifications de patterns sur des milliers de textes, créations de graphiques, rapports, etc.).

Ces techniques complémentaires peuvent être utilisées pour des analyses prédictives, des prescriptions, des visualisations, des analyses lexicales, des analyses de sentiments, de la reconnaissance de patterns et de nombreux autres cas d’usage.

6 exemples de cas d’usage possibles grâce à l’analyse de données textuelles

Voici quelques exemples de cas d’usage qui peuvent être réalisés grâce au Text Analysis :

- L’analyse des données des médias sociaux (commentaires, publications, avis, retours clients, réponses à un sondage) et l’analyse de produit (l’analyse des sentiments permet de comprendre les points faibles et les points forts de la marque et de ses produits).

- La surveillance de l’image de marque sur les réseaux sociaux. Les commentaires sur les médias sociaux, les blogs, les sites d’évaluations sont suivis en temps réels et permettent d’être informé immédiatement de tout événement négatif comme positif en lien avec la marque.

- Automatisation du service client : le Text Analysis ne remplace pas toutes les interactions humaines, mais permet aux agents de se concentrer sur les tâches les plus importantes grâce à un système de ticket. Le Text Analysis peut automatiquement identifier le sujet et la requête du client, et en se basant sur des résolutions passées, il pourra répondre au client (via un chatbot) et catégoriser la demande afin de la transmettre à la bonne personne.

- Business Intelligence : les chiffres sont faciles à analyser, mais ils sont limités. Les données textuelles permettent de comprendre le « Pourquoi » des phénomènes observés grâce aux chiffres. D’autre part, le texte est le format le plus répondu pour les informations commerciales.

- Ventes et marketing : le Text Analysis permet d’identifier des clients potentiels sur les réseaux sociaux qui expriment une intention d’achat. Il permet d’analyser automatiquement les réponses de prospect aux e-mails commerciaux, et plus encore.

- La gestion des connaissances : face à de grandes quantités de documents texte, il est parfois difficile de retrouver la bonne information au bon moment, comme dans le domaine légal ou dans le secteur de la santé, où les ressources textuelles sont très vastes. Les techniques de Text Analysis permettent de localiser l’information rapidement et avec précision, elles permettent même de proposer des informations en lien avec celle recherchée et de manière cohérente.

L’analyse de données textuelles : comment ça fonctionne ?

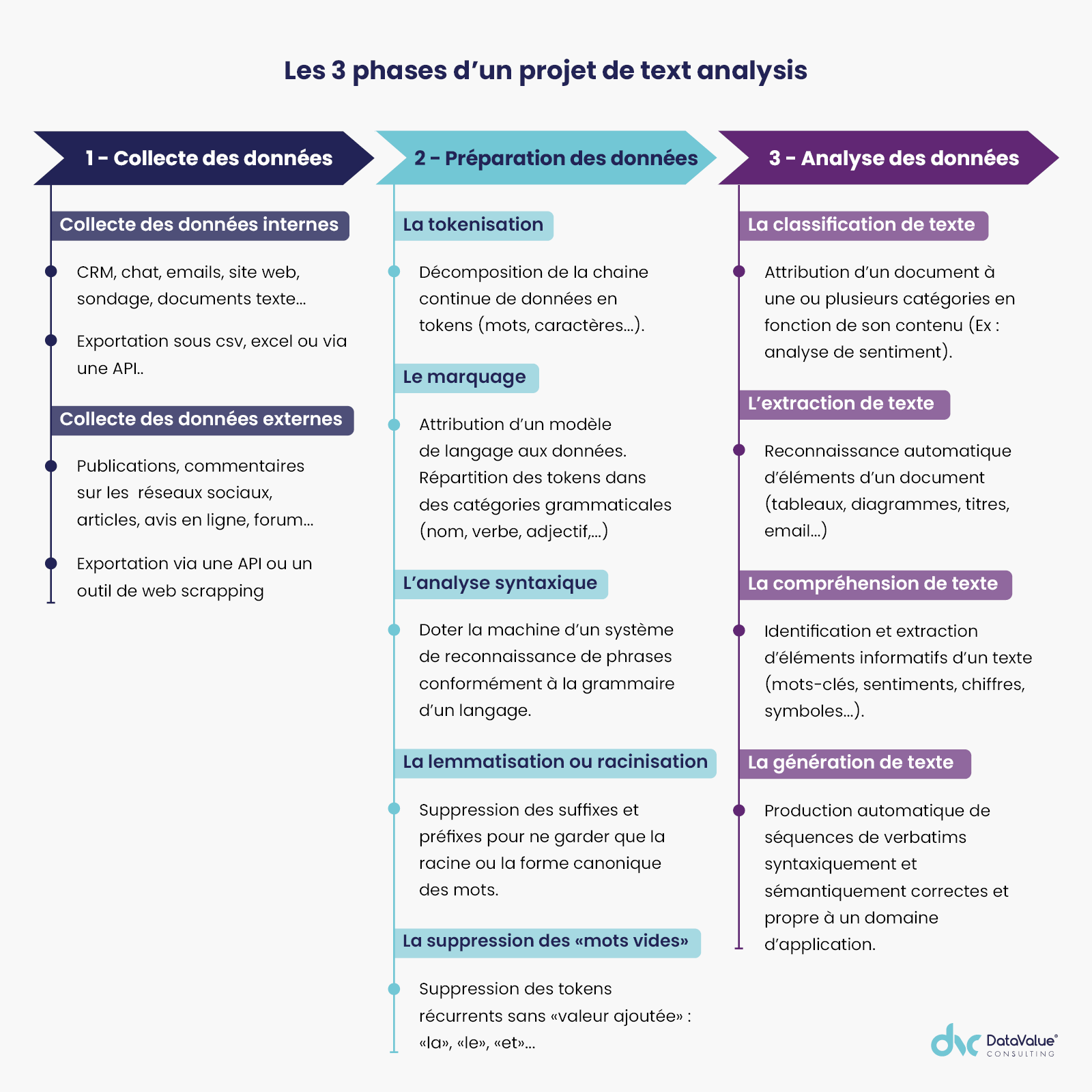

Un projet d’analyse de texte peut se diviser en 3 grandes phases que nous explicitons ci-dessous.

Phase préalable : la collecte de données

Si vous avez identifié une opportunité basée sur l’analyse de texte, demandez-vous quelles sont les données textuelles pertinentes pour le but visé. Où se trouvent ces données ? Sont-elles sur le web ? Sont-elles dans le système d’information de votre organisation ?

Les données textuelles peuvent être internes : CRM, chat, e-mails, sondages, bibliothèque de documents textuels, avis produits, score NPS (la vraie richesse du NPS c’est la question ouverte « Pourquoi avez-vous attribué cette note ? »), etc. Ces données sont faciles à exporter sous format CSV, Excel ou via une API.

Les données textuelles externes (réseaux sociaux, articles, avis en ligne, forums…) peuvent être collectées en passant par des APIs ou des outils de web scrapping.

La préparation de la donnée : le Text Analysis

L’organisation des données se fait en grande partie de manière automatique, l’analyse de texte repose sur plusieurs techniques du NLP (Naturel Language Processing), cela passe par plusieurs étapes.

Étape 1 : la tokenisation

Il s’agit de décomposer la chaine continue de données textuelles en tokens à l’aide d’algorithmes, en éliminant les parties sans signification (par exemple, les espaces). Les tokens peuvent être des caractères, des sous-mots ou des mots.

Exemples de tokens :

Des tokens de caractères : D-O-N-N-É-E-S

Des tokens de sous-mots : Don – nées

Des tokens de mots : Des – données – structurées

Étape 2 : le marquage ou balisage

Le marquage consiste à associer un modèle de langage aux données en attribuant une catégorie grammaticale à chaque token (nom, verbe, adjectif, ponctuation…). On peut ajouter à ses étiquettes syntaxiques, des étiquettes morphologiques (féminin, pluriel…).

Étape 3 : l’analyse syntaxique

C’est le processus de compréhension de la structure syntaxique qui permet à la machine de reconnaître des phrases d’un langage conformément à une grammaire. À partir des tokens créés, l’analyse syntaxique va dresser un arbre syntaxique en se basant soit sur la méthode des dépendances, soit sur la méthode des constituants.

Par exemple, la machine sera en mesure de capter les différents sens du mot “orange” dans la phrase : “Roland a mangé une orange orange à Orange et il l’a trouvée super bonne”.

Étape 4 : la lemmatisation et la racinisation

Cette étape consiste à supprimer des affixes (suffixes et préfixes) des mots pour ne garder que la racine du mot (aussi appelée stemme) ou la forme canonique (aussi appelé lemme) telle qu’elle apparaît dans le dictionnaire.

Les algorithmes de racinisation coupent la fin ou le début du mot en tenant compte des préfixes et suffixes qui lui sont couramment associés. Ce découpage sans discernement peut réussir, mais peut aussi conduire à des résultats parfois étranges.

Exemple : Optimal, Optimisation, Optimiser ont pour stemme Optim

La lemmatisation, plus fiable, fait appel à l’analyse morphologique des mots. Pour cela, il faut que l’algorithme puisse consulter des dictionnaires détaillés pour relier le mot à sa forme canonique.

La lemmatisation est la technique à favoriser : un lemme est la forme de base des mots et c’est sous cette forme qu’on les retrouve de manière unique dans les dictionnaires, alors que la racine peut être la même pour différents lemmes. L’analyse morphologique et le support des dictionnaires permet d’obtenir des résultats plus qualitatifs avec la lemmatisation.

Exemple : Optimal, Optimisation, Optimiser ont pour lemme Optimum.

Étape 5 : suppression des mots d’arrêts ou mots vides

Il s’agit d’éliminer tous les tokens qui reviennent de manière fréquente et qui n’ajoutent pas de valeur dans l’analyse de texte. Il existe de nombreuses listes de mots d’arrêts différentes pour chaque langue, selon les textes à analyser, il peut être nécessaire de compléter ses listes. On peut donner comme exemple de mots d’arrêt les mots tels que « a », « le », « et » …

L’analyse de données textuelles : les principales familles des usages du Text Analysis

La classification de texte

La classification de texte consiste à attribuer un document à une ou plusieurs catégories en fonction de son contenu. C’est un travail long et imprécis s’il est fait à la main. Des modèles d’analyses de texte par apprentissage automatique (Machine Learning) permettent d’effectuer ce travail en quelques secondes avec une précision inégalable.

La classification de texte permet de réaliser des analyses de sentiment (en détectant quand le texte dit quelque chose de positif ou négatif sur un certain sujet), elle permet aussi de détecter des sujets et des intentions (en déterminant les sujets et les objectifs qu’évoque un texte).

La classification basée sur le Machine Learning permet de faire des prédictions qui reposent sur ce que la machine apprend des observations passées. Des techniques d’évaluation de précision permettent de suivre les performances d’un classificateur.

L’extraction de texte

L’extraction de texte consiste à reconnaître des informations, par exemple, pour détecter automatiquement des éléments de mise en page (tableaux, diagrammes, titres, paragraphes…), des adresses e-mails, des noms d’entreprises ou encore les mots-clés d’un document.

Il y a l’extraction d’expressions régulières qui consiste à associer un motif de caractères (par exemple, une adresse e-mail) à un tag, les correspondances à ce tag pourront être extraites automatiquement. Cette approche présente des avantages à condition de trouver les bons motifs pour trouver l’information que vous cherchez.

L’extraction peut aussi se faire sous une approche statistique avec les champs aléatoires conditionnels (CRF) fondés sur l’apprentissage automatique. Cette approche permet d’apprendre aux modèles à extraire des informations en pondérant plusieurs caractéristiques de séquences de mots. Cela permet d’obtenir des modèles plus riches et plus complexes que l’extraction d’expressions régulières.

La génération de texte

La génération de texte consiste à produire automatiquement une ou plusieurs séquences de verbatims contextualisés sous une forme syntaxiquement et sémantiquement correcte. Aussi connue sous l’acronyme GAT (Génération Automatique de Texte), elle vise à transformer en texte, le sens déduit à partir d’une plus grande variété de verbatims variés propre à un domaine d’application (par exemple : météorologie pour la production de bulletins météo ; la bourse pour la production de synthèse d’avis d’experts…).

La compréhension de texte

La compréhension de texte consiste à identifier et à extraire des éléments informatifs dans un texte (mots-clés, sentiments, chiffres, symboles…). Les textes de type descriptif, narratif et argumentatif sont traités différemment en fonction du domaine d’application auquel il réfère.

Les mécanismes mis en œuvre dans chacun de ces cadres sont représentatifs des processus cognitifs utilisés pour la compréhension en général. Ces mécanismes peuvent être utilisés dans des applications variées, telles que :

- Piloter l’amélioration continue : analyse de l’expérience client et réalisation d’un plan d’amélioration ;

- Faire des enquêtes : création, diffusion, analyse et communication ;

- Faciliter l’adhésion des équipes : engagement des collaborateurs, conversion à une approche Customer centric ;

- Mesurer la satisfaction : automatisation de la collecte des retours clients et avoir une vision objective de la qualité de l’expérience client.

Prenons un exemple concret de résultats que l’on peut obtenir en appliquant ces techniques. Un vendeur de vêtements souhaitant analyser les commentaires google de son magasin pourra profiter d’informations précises et globales sur ces avis, sans avoir à tous les lire. On pourra alors imaginer une visualisation comme ci-dessous.

DataValue Consulting industrialise l’analyse de données textuelles avec sa plateforme NEREIDES

Notre LAB’Innovation conçoit, développe et déploie dans des systèmes d’information existants, des composants algorithmiques génériques spécifiques qui facilitent et rendent ludique le traitement des données textuelles massives.

Notre accélérateur NLP (Plateforme de Text Analysis NEREIDES) est doté des dernières avancées issues de nos résultats de travaux R&D et de veille scientifique et technologique active. Grâce aux outils de cette plateforme, nous aidons nos clients à transformer leurs banques de données non structurées (commentaires, avis en lignes…) en informations actionnables, tout en intégrant des technologies de Text Analysis dans leur système d’information. Des résultats exploitables sont obtenus en moins de 3 semaines.

Notre accélérateur NLP fournit 2 niveaux de proposition de valeur.

Le premier niveau de proposition contient les éléments suivants :

- Un plan thématique générique portant sur la relation client dans son ensemble ;

- Une reconnaissance des entités nommées ;

- Des nuages de mots clés et/ou des cooccurrences ;

- Une analyse du sentiment (positif, négative, mixte, neutre) ;

- Une analyse des émotions primaires…

Puis un second niveau contenant entre autres :

- Des plans thématiques spécifiques ;

- Des analyses du risque client (par exemple : risque d’attrition), et des opportunités (par exemple : intérêt du client pour un service), ainsi que des matrices associées ;

- Une identification des suggestions (par exemple : un service manquant dans l’offre proposée) ;

- Des émotions plus diverses que les émotions primaires…

Pour plus d’informations, consultez la page dédiée au LAB’Innovation.

Conclusion

Les données textuelles sont si nombreuses et regorgent d’informations valorisables. Pour pouvoir en profiter, il est nécessaire de préparer ces données avec les techniques de Text Analysis.

Une fois les données préparées, elles pourront être analysées grâce aux techniques associés au Text Analytics. Enfin, les résultats de ces analyses devront être couplés à des outils de visualisation de données qui permettront d’identifier et de comprendre facilement les informations pertinentes.